¿Recuerdas este post ‘Agile Alliance Technical Debt Initiative‘ en abril, para anunciar la publicación de algunos entregables de nuestro grupo? Bueno, tuvimos nuestro workshop 2016 hace un par de semanas, y esto ha sido un gran evento y un taller productivo con algunos resultados prometedores para este año.

En primer lugar quisiera recordaros acerca de la Agile Alliance Technical Debt Initiative: se encuentra todo en la página correspondiente del sitio web de Agile Alliance:

- Una introducción sobre la deuda técnica, revisada por el propio Ward Cunningham.

- El modelo de análisis de la deuda técnica (A2DAM) que hemos desarrollado, con la contribución de once proveedores de software, como una lista sencilla de «buenas prácticas que, cuando no son respetadas, generan deuda técnica».

- Una publicación que personalmente me gusta mucho acerca de cómo administrar la deuda técnica en proyectos ágiles, a diferentes niveles de Release, Iteración y Story del proyecto.

- Y por último pero no menos importante, los dados de la deuda, que tuvimos la oportunidad de jugar con nuestros amigos madrileños.

Qué, ¿se me olvidó decir que nuestro taller tuvo lugar en Madrid? Un buen lugar para tres días de reunión y algunos intercambios muy creativos.

Modelado de la deuda técnica

No voy a enumerar todo lo que hicimos y lo que planificamos para 2016, pero hemos tenido algunas interesante presentaciones, de Declan sobre System archetypes, y de Dan acerca de unos trabajos que él hizo en esta área. La idea es identificar patrones en la creación de deuda técnica y su evolución, basándonos no solamente en la teoría, sino también en experiencias concretas.

Thierry está trabajando en un modelo dinámico de la deuda técnica, donde veo mucho potencial. Imagínate que puedas utilizar una herramienta para evaluar el impacto de tu deuda técnica, cambiando la configuración y la configuración con el fin de adaptarla a tu contexto, tus proyectos, tus prácticas ágiles, etc. Esto haría que la deuda técnica sea visible para tu organización, y ayudará a entender cómo ella puede evolucionar en el corto y largo plazo, dependiendo de las decisiones que se toman para gestionarla.

Meetup MadriAgil

Nos aprovechamos de nuestra presencia en la capital española para organizar un evento con MadriAgil. Jean-Louis hizo una breve presentación de nuestro grupo, los objetivos, el trabajo ya realizado y Tom presentó algunas diapositivas sobre la deuda técnica.

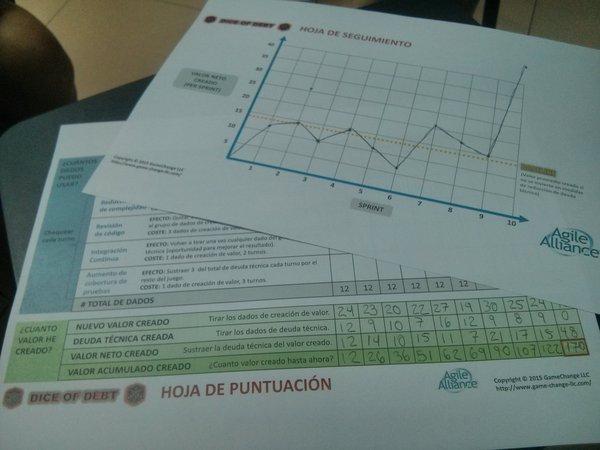

Luego, empezamos una sesión del juego de ‘Dice of Debt’, con la formación de equipos de cuatro jugadores que tuvieron que decidir una estrategia para hacer frente a la deuda técnica.

Luego, empezamos una sesión del juego de ‘Dice of Debt’, con la formación de equipos de cuatro jugadores que tuvieron que decidir una estrategia para hacer frente a la deuda técnica.

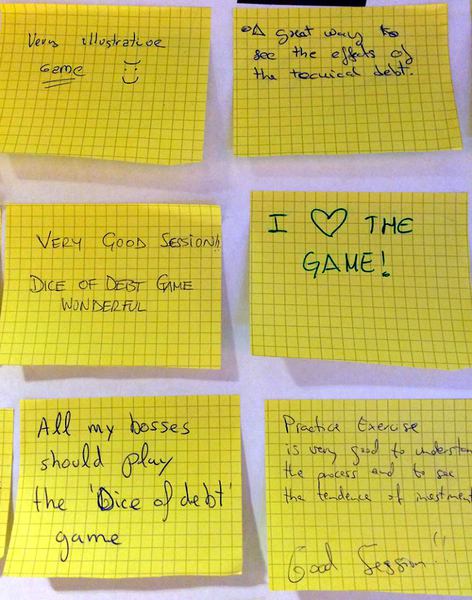

Todos lo hemos disfrutado, muy divertido, y el feedback fue muy bueno.

Todos lo hemos disfrutado, muy divertido, y el feedback fue muy bueno.

Fue también una buena oportunidad para nuestro grupo para aprender algunas lecciones:

Fue también una buena oportunidad para nuestro grupo para aprender algunas lecciones:

- En los casi 40 participantes, una buena proporción de ellos asistía por primera vez a un Meetup ágil: la deuda técnica es un tema que interesa y atrae, probablemente porque es una preocupación real para muchas personas.

- Declan pidió a todos evaluar el nivel de deuda técnica en su proyecto, en una escala del 1 (bueno) a 5 (muy malo): una mayoría de 3 y 4.

- Hasta el 80% de los participantes utilizan prácticas Scrum en su proyecto. Esto me confirma en la idea que se necesitan conocimiento y métodos tipo ‘how to’ para gestionar la deuda técnica de manera operacional en proyectos ágiles.

Todos estábamos muy contentos después de este evento, y a ver si podemos hacer unos otros, con otras comunidades ágiles en otras ciudades.

Estamos trabajando en una versión online del juego de ‘dados de la deuda’. Otro proyecto es crear un quizz para poder realizar una auto-evaluación de sus conocimientos sobre la deuda técnica. Está planificado un webinar, quizás más de uno, ya que hay mucho que decir sobre el tema.

Fue genial volver a reunirnos de nuevo para este workshop, no todo se puede hacer siempre con Hangouts, así que vamos a terminar con una foto de nuestro grupo:

Agile Alliance Technical Debt Initiative Workshop – Madrid 2016